认知全重在人工智能顶级国际会议 ICLR 2026 发表化学大模型多层次多维度能力评估新基准

近日,认知智能全国重点实验室联合研究团队——中国科学技术大学陈恩红教授团队与科大讯飞研究院 AI for Science 团队,在人工智能领域顶级国际会议 ICLR 2026 发表最新研究成果,论文提出了多层级、细粒度的化学能力评测框架 ChemEval,并系统性揭示了大语言模型在化学领域的真实能力边界。该工作为 AI for Science 方向中“如何科学地评估大模型是否真正理解化学”这一核心问题,提供了完整、可复现且具有学术深度的答案。

• 论文标题: ChemEval: A Multi-level and Fine-grained Chemical Capability Evaluation for Large Language Models

• 论文地址: https://openreview.net/forum?id=JrqjSkEPrX

为什么需要“化学专用”的大模型评测?

近年来,大语言模型在文本理解、知识问答和通用推理任务中展现出惊人的能力,也逐渐被引入到化学文献分析、反应预测和分子设计等科学场景中。然而,一个关键问题长期被忽视——

模型“看起来会化学”,是否真的具备化学研究所需的能力?

现有主流评测基准(如 MMLU、SciEval 等)大多以通用学科或浅层科学问答为主,难以刻画化学研究中高度专业、层次分明且跨模态的能力需求。即便是已有的化学评测工作,也往往局限于少量任务或单一能力维度,难以反映模型在真实科研场景中的综合表现。

针对这一核心缺口,研究团队提出了ChemEval ——一个从化学研究者视角出发设计的系统化评测框架,对大语言模型在化学领域的能力进行分层、分维度、分任务的精细诊断。

ChemEval ——从化学研究者视角出发的评测体系

ChemEval 并非简单堆叠题目,而是围绕化学研究的认知过程,构建了一套四层递进式评测结构:

- 基础与进阶化学知识问答:考察模型对核心化学概念、定量计算与理论知识的掌握;

- 化学文献理解与信息抽取:评估模型从论文、表格和图像中提取关键信息并进行归纳生成的能力;

- 分子层级理解:覆盖分子命名、结构转换、性质预测与描述等核心分子认知任务;

- 科学推理与化学推断:包括逆合成分析、反应条件推荐、产物预测与机理分析等高阶任务。

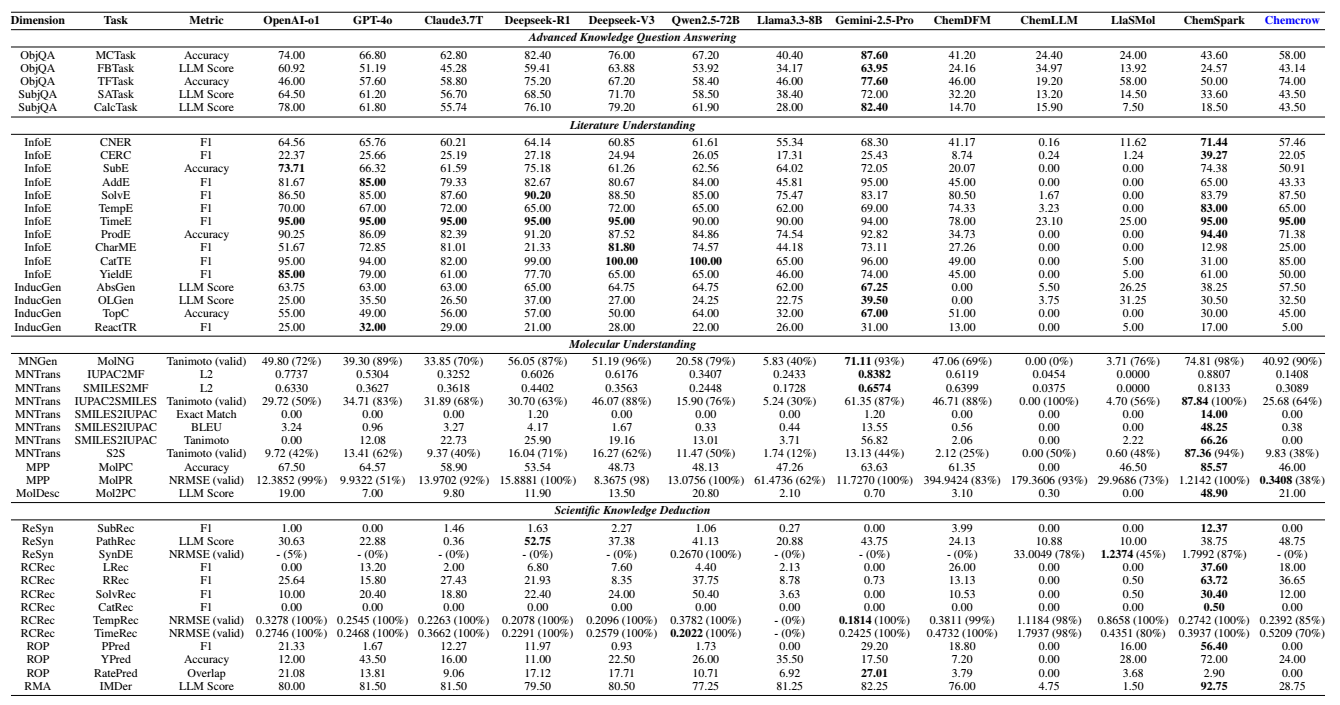

整个评测体系共包含13 个能力维度、62 项具体任务,既涵盖文本任务,也系统引入分子结构图、光谱图等多模态输入,贴近真实化学研究流程。

更重要的是,ChemEval 的数据并非简单复用已有公开数据,而是结合开源数据集与化学领域专家人工构建的数据,通过严格的三阶段标注与审校流程,确保科学性与评测可靠性。

通用大模型 vs. 化学专用模型,谁更“懂化学”?

基于 ChemEval,研究团队对主流通用大语言模型与化学专用模型进行了系统评测,得到了一系列具有启发性的结论:

- 通用大模型在化学文献理解、指令遵循和部分推理任务中表现突出,但在涉及分子结构、反应机理等深度化学知识时明显乏力;

- 化学专用模型在术语理解、分子性质等专业任务上具备优势,但往往牺牲了通用语言理解能力,存在“灾难性遗忘”和指令不稳定问题;

- 单纯增加模型规模或引入“思考链”并不足以解决复杂化学任务,瓶颈并不在推理长度,而在领域知识建模与表示能力本身;

- 在多模态化学任务中,当前模型在简单结构识别上尚可,但在综合结构识别 + 机理推断的任务中普遍存在显著困难。

这些结果以系统性、量化方式揭示了当前大模型在化学研究中的真实能力边界,也为后续模型设计与训练方向提供了明确指引。

为 AI for Science 提供“标尺”,而不只是排行榜

不同于“刷榜型”评测工作,ChemEval 更强调诊断价值:

- 它能够精确定位模型在化学研究流程中“卡在哪一层能力”;

- 揭示通用能力与领域能力之间的结构性矛盾;

- 为化学大模型的训练策略、数据构建和工具增强提供可操作的参考依据。

研究团队认为,真正推动 AI for Science 的关键,不是让模型在单一任务上表现更好,而是让模型在完整科学认知链条中更可靠、更可解释,ChemEval 正是朝这一目标迈出的重要一步。

实验室持续推进 AI × Chemistry 深度融合

该工作是认知智能全国重点实验室在科学智能与化学大模型评测方向的重要进展之一。近年来,实验室团队围绕“模型是否真正理解科学”这一核心问题,持续在科学推理、多模态理解和领域评测体系建设方面开展系统研究,此前实验室在Nature旗下《Communications Chemistry》发表题为《Evaluating Large Language Models on Multimodal Chemistry Olympiad Exams》的研究论文,代表了实验室研究团队在“科学视觉推理”方向上的重要延伸。

未来,团队将进一步探索化学大模型与专业仿真工具、实验数据和多模态信息的深度融合,推动 AI 从“辅助理解”走向“参与发现”,为化学研究范式变革提供坚实的智能基础。