首超人类水平!实验室登顶机器阅读理解评测SQuAD 2.0

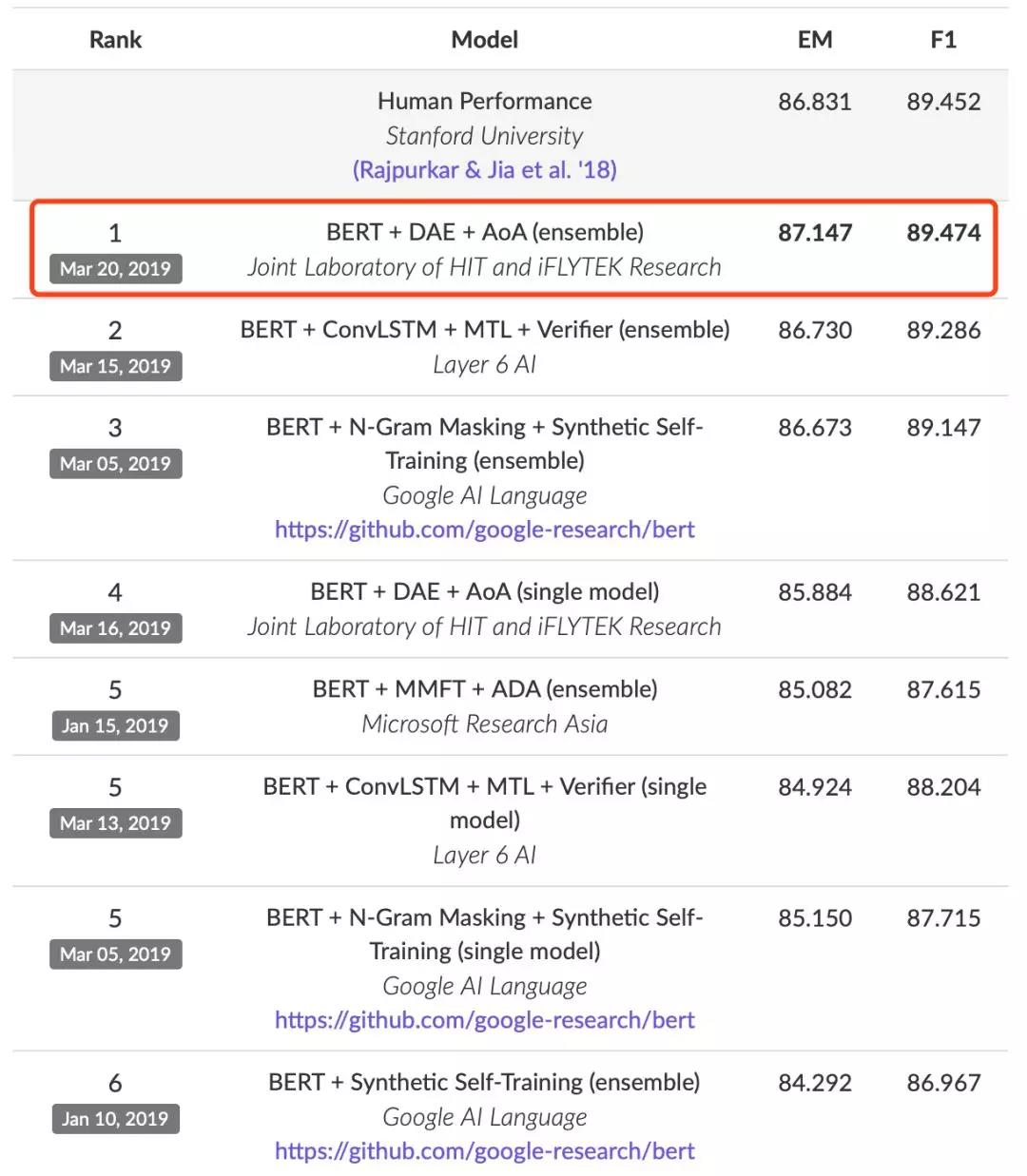

2019年3月20日,哈工大讯飞联合实验室与河北省讯飞人工智能研究院联合团队在由斯坦福大学发起的国际权威机器阅读理解评测SQuAD 2.0(Stanford Question Answering Dataset)中荣登榜首,所有指标均超过人类平均水平并且创下该评测的新纪录,再次展现了其在机器阅读理解领域的核心技术国际领先地位,也是人工智能技术在机器阅读理解领域的一项重要里程碑。

国际权威机器阅读理解评测SQuAD自2016年发布以来受到了业界的广泛关注,吸引了众多国内外知名研究机构和高校,其中包括谷歌、微软亚洲研究院、IBM研究院、阿里巴巴达摩院、平安科技、上海交通大学、复旦大学等。

SQuAD从1.0、1.1再到2.0,比赛难度持续升级。在谷歌、微软亚洲研究院、IBM研究院、阿里巴巴达摩院、平安科技、上海交通大学、复旦大学等众多参赛的国内外知名研究机构和高校中,科大讯飞从2017年成为首次取得赛事榜首的中国本土研究机构起,已四次刷新比赛榜单第一。

SQuAD 2.0评测在基于篇章片段抽取的阅读理解任务基础上(例如SQuAD 1.1评测)进一步提高了解答难度,对机器阅读理解模型提出了新的挑战。其主要区别是加入了“不可回答的问题”,即通过阅读篇章无法找到答案的问题。机器阅读理解模型需要通过阅读篇章和问题,判断所提出的问题是否能够通过篇章内容进行回答。如果可以回答,则给出篇章中的某个连续片段作为答案;如果不可回答,则对该问题进行“拒答”,而不是给出似是而非的答案。

首次超越人类水平的背后,得益于提交的“BERT + DAE + AoA”模型,融合了业界领先的自然语言语义表示模型BERT以及团队持续积累和改进的层叠式注意力机制(Attention-over-Attention,AoA),将该评测的相关技术指标推向新的高度,其中EM指标(精准匹配率)达到87.147,F1指标(模糊匹配率)达到89.474,均超过人类在该数据集上的平均水平(EM: 86.831, F1: 89.452)。