阅读理解难度翻倍?认知智能国家重点实验室刷新逻辑推理阅读理解挑战赛ReClor纪录

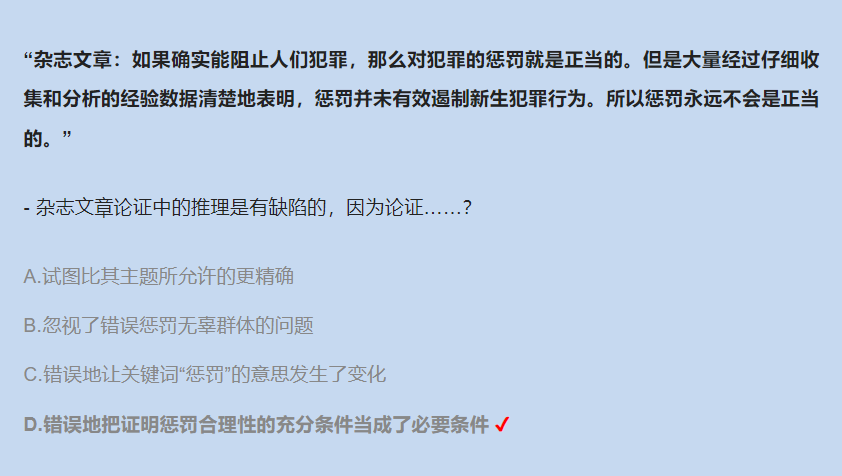

先来看一道阅读理解题目:

想要正确解答,首先要阅读并理解给出的片段内容,明确任务是找出所给篇章中的推理漏洞;

其次需要明确“犯罪”、“惩罚”、“遏制”等词语的概念以及互相之间的影响关系;

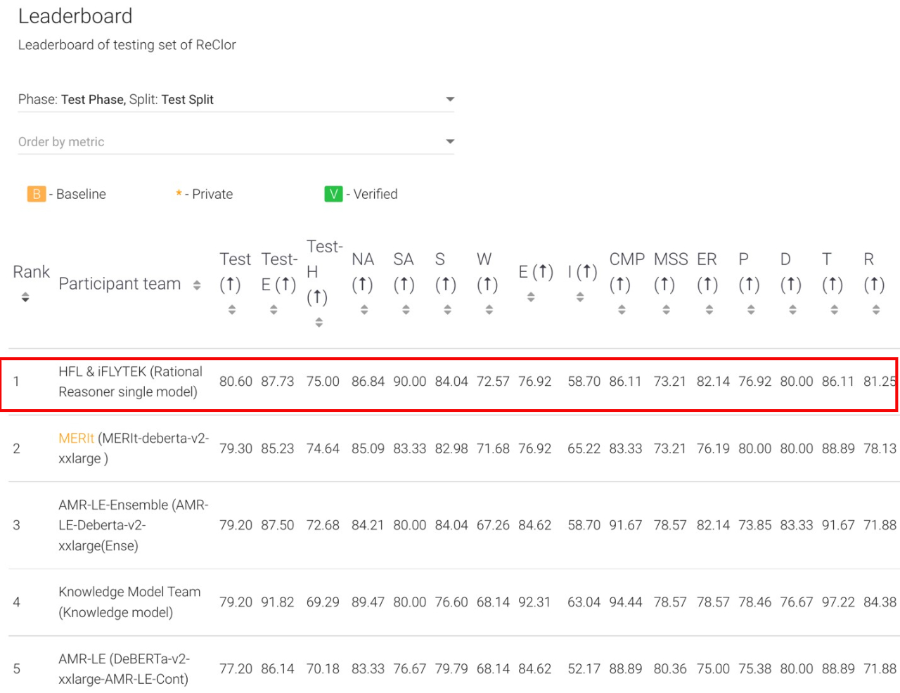

从而理解到得出结论之前,题目给出的内容片段仅提供了“阻止犯罪是惩罚正当的充分不必要条件”的关系,但结论却是基于“必要不充分条件”的。这些对于人类来说都难度颇高的逻辑推理问题,机器的表现会如何?近日,在挑战难度升级的逻辑推理机器阅读理解挑战赛ReClor上,由科大讯飞承建的认知智能国家重点实验室荣登榜首,以单模型准确率80.60%超越前榜单最好成绩。这也是今年继CommonsenseQA 2.0、OpenBookQA、QASC赛事之后,实验室在机器阅读理解领域获得的第4个冠军。

ReClor是由新加坡国立大学发布的逻辑推理机器阅读理解领域代表性数据集,该数据集囊括了来自美国司法学院入学考试(LSAT)和美国管理学科研究生入学考试(GMAT)中的逻辑推理相关题目。在挑战难度升级的情况下,该赛事也吸引了谷歌、微软、腾讯、复旦大学、悉尼大学等知名企业、研究机构和高校的关注和参与。

相较于此前传统典型的机器阅读理解任务,以及句子级推理相关的系列任务,ReClor具有推理信息密度大、推理上下文较长等特点,并且问题类型覆盖了充分必要条件、主旨推断、错误识别等17个推理类型,对机器阅读理解模型的信息理解和应用能力提出了极高的要求。ReClor数据集中的每一个题目都由篇章、问题和四个选项构成,需要机器完成篇章阅读、正确理解问题,并从选项中找出正确答案。参赛模型不仅需要捕捉统计学角度的字词特征、理解文字的表面含义,还需要基于所提供的各个事件、论据之间的关系进行推理,从而得出逻辑层面新的结论。

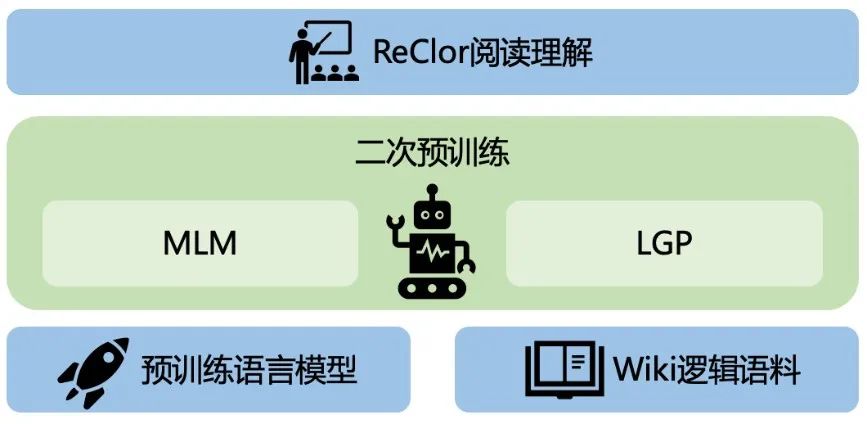

本次比赛中,认知智能国家重点实验室提出了推理系统Rational Reasoner。该推理系统从预训练阶段进行突破,基于开源的维基百科数据,抽取出逻辑信息密度较大的语料,使用MLM联合基于词级别特征设计的逻辑预训练任务LGP (LoGic Pretraining), 对通用预训练语言模型进行了二次预训练,以针对性地增强其对文本中的逻辑信息的把控水平和推理能力,使得预训练模型在逻辑推理任务上取得更好的效果。

此前,认知智能国家重点实验室已多次在国际机器阅读理解评测赛事中取得优异成绩,如权威赛事SQuAD 2.0中全球首次超过人类平均水平,对话型阅读理解评测CoQA和QuAC冠军,多步推理阅读理解HotpotQA双赛道冠军,多模态阅读理解评测VCR冠军,常识推理挑战赛CommonsenseQA 2.0冠军,科学常识阅读理解OpenBookQA冠军,常识推理挑战赛QASC冠军等。

此次刷新难度升级的ReClor挑战赛榜单成绩,标志着机器在理解方面进一步“融会贯通”,从有效理解文本表面意思,进阶到能基于已有知识进行逻辑推理,将机器阅读理解技术也提升至新的高度。在实际应用落地中,该项技术能够显著提升对文本理解和应用有较高要求的复杂场景中的系统表现,如教育领域的智能批阅、司法领域的案情分析、医疗领域的病情诊断等。成绩的背后,源于讯飞持续深入认知智能领域前沿技术研究,不断实现创新突破。未来讯飞将持续发力,围绕“讯飞超脑2030计划”深耕,推动真正实现机器“能理解会思考”的目标。