哈工大讯飞联合实验室发布中文RoBERTa-wwm-ext预训练模型

哈工大讯飞联合实验室(HFL)相继发布了基于Whole Word Masking(WWM)的中文预训练BERT模型(BERT-wwm,BERT-wwm-ext)以及中文预训练XLNet模型(XLNet-mid,XLNet-base),受到了业界广泛关注以及下载使用。近期,Facebook提出的RoBERTa模型进一步刷新了多个英文数据集的最好成绩,成为目前最流行的预训练模型之一。哈工大讯飞联合实验室结合中文Whole Word Masking技术以及RoBERTa模型发布中文RoBERTa-wwm-ext预训练模型。该模型在使用上与中文BERT系列模型完全一致,无需任何代码调整即可使用。通过实验验证该模型在多个自然语言处理任务中取得了显著性能提升。我们欢迎各位专家学者下载使用,进一步促进中文信息处理的研究发展。

项目地址:https://github.com/ymcui/Chinese-BERT-wwm

中文RoBERTa-wwm-ext

本次发布的中文RoBERTa-wwm-ext结合了中文Whole Word Masking技术以及RoBERTa模型的优势,得以获得更好的实验效果。该模型包含如下特点:

- 预训练阶段采用wwm策略进行mask(但没有使用dynamic masking)

- 取消了Next Sentence Prediction(NSP)

- 不再采用先使用max_len=128的数据预训练然后再用max_len=512的数据预训练的模式,取而代之的是直接使用max_len=512的数据进行预训练

- 训练步数适当延长,共计训练了1M步

本次使用的训练数据与BERT-wwm-ext完全相同(总词数为5.4B),为了保持命名标记一致,我们特指本次发布的模型为RoBERTa-wwm-ext以表示采用了大规模训练数据而非仅使用了中文维基百科数据。

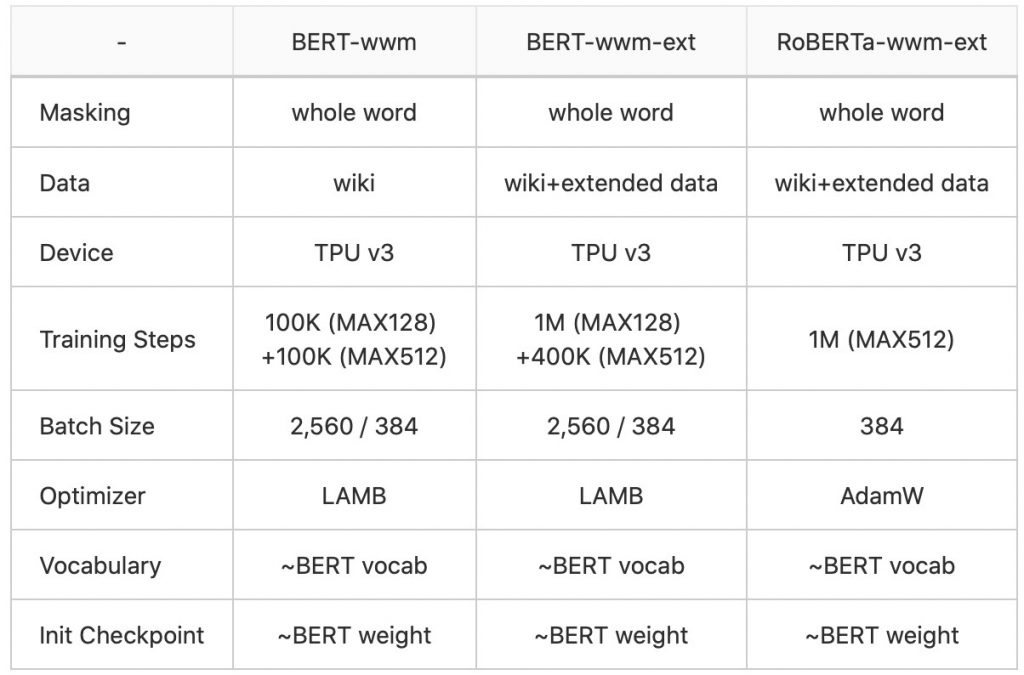

模型对比

以下是目前哈工大讯飞联合实验室已发布的中文预训练BERT系列模型。所有发布的BERT模型均是BERT-base派生模型,即由12层Transformers组成,Attention Head为12个,隐层维度是768。

基线测试结果

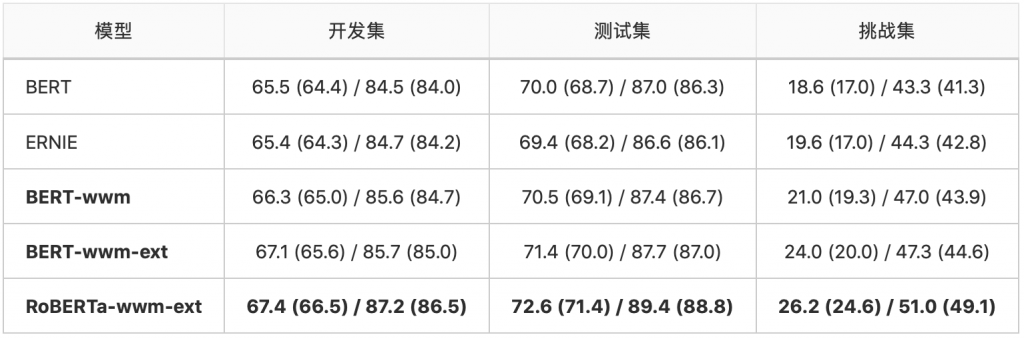

中文简体阅读理解:CMRC 2018

CMRC 2018是哈工大讯飞联合实验室发布的中文机器阅读理解数据。根据给定问题,系统需要从篇章中抽取出片段作为答案,形式与SQuAD相同。

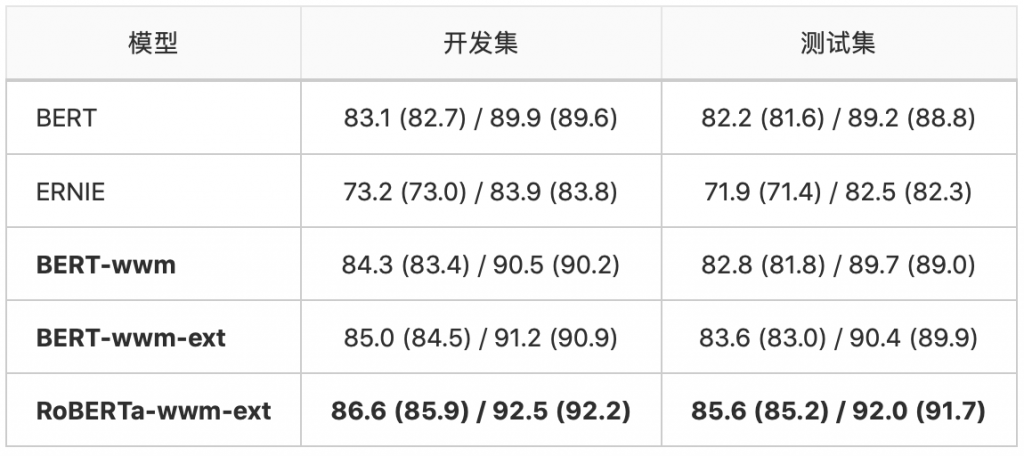

中文繁体阅读理解:DRCD

DRCD数据集由中国台湾台达研究院发布,其形式与SQuAD相同,是基于繁体中文的抽取式阅读理解数据集。

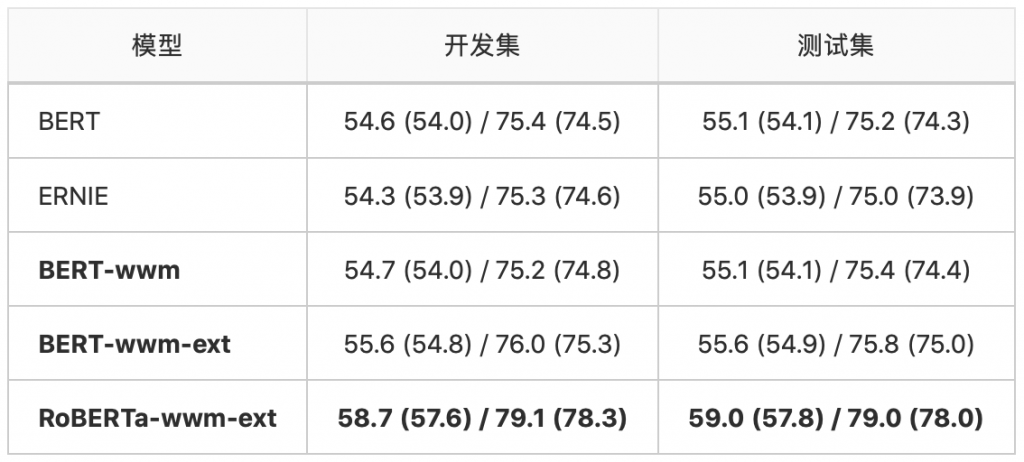

司法阅读理解:CJRC

CJRC数据集是哈工大讯飞联合实验室发布的面向司法领域的中文阅读理解数据集。需要注意的是,实验中使用的数据并非官方发布的最终数据,结果仅供参考。

自然语言推断:XNLI

XNLI是由 Facebook和纽约大学发布的自然语言推断数据集,可以看做是一个三分类任务。