对话型阅读理解挑战赛CoQA中夺冠

2018年12月12日,哈工大讯飞联合实验室(HFL)在由斯坦福大学发起的对话型机器阅读理解挑战赛CoQA(Conversational Question Answering Challenge)中获得冠军。

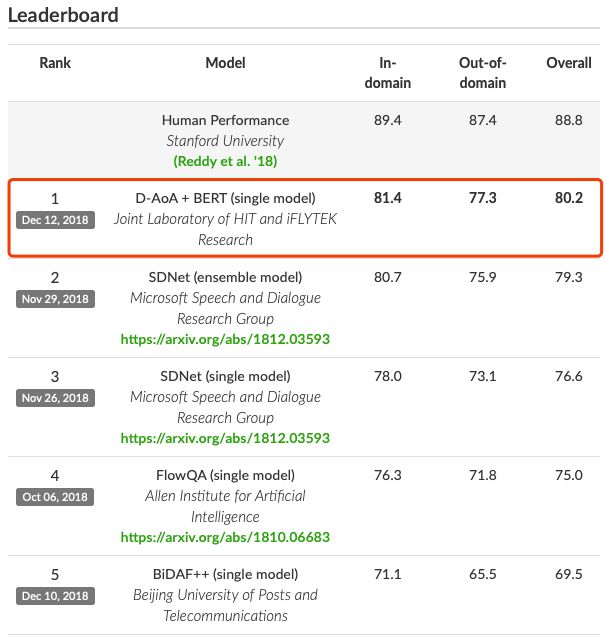

在该挑战赛中,哈工大讯飞联合实验室凭借所研发的D-AoA + BERT模型,全面刷新所有评价指标,以总成绩80.2%位列该挑战赛的榜首,同时也是首个总成绩超过80%的系统,与人类在该数据上的平均水平差距进一步缩小。

值得一提的是,哈工大讯飞联合实验室本次提交的单模型效果显著优于榜单上已有的多模型融合结果,凸显了哈工大讯飞联合实验室在机器阅读理解技术上的国际领先水平。CoQA挑战赛在2018年8月正式启动,吸引了众多国内外知名研究机构和高校,其中包括微软、艾伦研究院(AI2)、北京邮电大学、复旦大学等。

(截止2018年12月12日)

与业界所熟知的机器阅读理解评测SQuAD一样,CoQA挑战赛同样由斯坦福大学发起,但侧重点与SQuAD评测不同。CoQA数据集中的问题不再是单轮的一问一答的形式,而是扩展到多轮的对话交互。从示例中我们可以看出,问题Q2的解答需要依赖上一轮的问题Q1,使得问题理解的难度大大增加。

另外一个不同之处在于,CoQA数据的答案不再是完全来自于篇章中的某一个连续片段,其答案可以是Yes/No或其它一些没有出现在篇章中的内容,使得该数据集更加符合真实的应用场景。总的来说,CoQA挑战赛更加注重机器阅读理解技术在多轮对话中的应用,预示着机器阅读理解未来的研究方向,具有前瞻性、挑战性和实用性。

哈工大讯飞联合实验室资深研究员、阅读理解组研究主管、哈工大SCIR博士生崔一鸣介绍:将机器阅读理解技术和人机对话任务进行结合是自然的。相比传统生硬的一问一答的形式,通过多轮人机对话完成阅读理解并获取所需要的信息更加符合真实的应用场景,也是未来机器阅读理解技术落地的一大方向。

这标志着科大讯飞的机器阅读理解能力不断在进化。从去年开始,科大讯飞就已经从探索技术无人区的角度出发,开始尝试在阅读理解与问题拒答领域进行技术拓展,不论是参与今年斯坦福大学的SQuAD2.0评测,还是在本次的CoQA挑战赛中夺冠,都进一步佐证了科大讯飞在自然语言处理等基础研究上的前瞻性。

当然,在科大讯飞看来,参加挑战赛不是根本目的,技术+应用才是硬道理。自然语言处理一直是实现人机交互、人工智能的重要技术基石,机器阅读理解正是这一领域的一个研究焦点;同样,让机器实现“能听会说”到“能理解会思考”,也一直是科大讯飞所肩负的使命和方向。

机器阅读理解技术拥有广阔的应用场景,例如在产品的精准问答、开放域的问答上都会起到有力的支撑作用,讯飞也在不断探索机器阅读理解技术的应用落地。